Selama satu dekade terakhir, industri teknologi terbiasa dengan istilah hyperscale sebagai tulang punggung komputasi awan. Namun, ledakan kecerdasan buatan generatif telah memaksa industri ini berevolusi lebih cepat dari perkiraan. Kita kini meninggalkan era pusat data konvensional dan memasuki fase “Mega-Hyperscale” atau sering disebut sebagai AI Superfactory.

Perbedaan utamanya terletak pada densitas energi dan karakteristik beban kerja. Jika cloud tradisional melayani jutaan permintaan kecil yang terpisah, AI membutuhkan ratusan ribu chip yang bekerja serentak sebagai satu otak raksasa. Hal ini mengubah total cara fasilitas ini dibangun dan dioperasikan.

Secara definisi, AI Superfactory adalah fasilitas data center yang dirancang khusus untuk melatih satu model kecerdasan buatan yang masif, bukan sekadar menyimpan data atau menjalankan aplikasi web.

Berbeda dengan data center cloud tradisional yang terdiri dari ribuan server independen, AI Superfactory menghubungkan puluhan hingga ratusan ribu unit pemrosesan grafis (GPU) menjadi satu klaster komputasi raksasa. Dalam fasilitas ini, seluruh gedung berfungsi layaknya satu komputer super (single supercomputer). Tujuannya adalah meminimalkan latensi data antar-chip dan memaksimalkan efisiensi daya untuk proses pembelajaran mesin yang intensif.

Untuk memahami skala masif ini, kita bisa melihat apa yang terjadi pada pemain teknologi terbesar dunia saat ini. Pelatihan satu model AI mutakhir kini membutuhkan fasilitas yang dibangun dengan kecepatan dan kapasitas yang belum pernah terjadi sebelumnya.

Sebagai contoh, fasilitas superkomputer “Colossus” milik xAI di Memphis dibangun hanya dalam 122 hari untuk menampung 100.000 GPU yang kini sedang berekspansi menuju 200.000 unit. Skala ini menciptakan kebutuhan energi yang begitu besar dan mendadak, sehingga pengembang harus menggunakan pembangkit listrik mandiri karena jaringan lokal tidak sanggup menyuplai daya tambahan secara instan.

Di sisi lain, hambatan utama industri saat ini bukan lagi ketersediaan chip, melainkan ketersediaan soket listrik. Petinggi Microsoft bahkan sempat mengungkapkan bahwa mereka memiliki ribuan GPU canggih yang tersimpan di gudang karena belum ada kapasitas daya yang siap untuk menyalakannya. Ini membuktikan bahwa dalam era AI, daya listrik adalah komoditas paling berharga.

Dahulu, fasilitas berkapasitas 30 hingga 50 Megawatt (MW) sudah dianggap sebagai kampus hyperscale besar. Namun karena kebutuhan pelatihan AI yang rakus energi, definisi “besar” telah bergeser drastis. Fasilitas modern kini dirancang dengan target ratusan Megawatt hingga skala Gigawatt dalam satu lokasi kampus.

Pergeseran standar ini terjadi secara global, termasuk di Asia. Para penyedia infrastruktur kini berlomba membangun kapasitas jumbo untuk mengakomodasi gelombang permintaan AI regional. Sebagai ilustrasi, Digital Edge DC tengah aktif mengembangkan fasilitas berkapasitas di atas 100MW hingga 300MW di beberapa negara seperti Korea Selatan, India, Indonesia, dan Thailand. Kesiapan menyediakan infrastruktur berskala ratusan megawatt kini menjadi syarat mutlak bagi pemain data center yang ingin tetap relevan di pasar global.

Peralihan ke “AI Superfactory” juga mengubah spesifikasi teknis di dalam gedung secara fundamental. Rak server tradisional untuk aplikasi web biasanya hanya mengonsumsi 5-10kW daya. Sebaliknya, rak AI modern yang berisi chip generasi terbaru seperti NVIDIA Blackwell dapat mengonsumsi lebih dari 100kW per rak.

Implikasinya sangat besar pada sistem pendinginan. Pendingin udara (AC) konvensional tidak lagi memadai untuk menangani panas yang dihasilkan oleh densitas setinggi itu. Fasilitas masa depan kini wajib mengadopsi teknologi liquid cooling (pendingin cair) yang dialirkan langsung ke chip untuk menjaga performa komputasi tetap optimal.

Arah pengembangan pusat data sudah sangat jelas. Kita sedang bertransisi dari sekadar fasilitas penyimpanan data menjadi fasilitas pembangkitan kecerdasan digital. Dalam era Mega-Hyperscale ini, pusat data tidak lagi hanya dilihat dari luas persegi bangunannya, melainkan dari seberapa besar dan andal pasokan daya yang dimilikinya. Pemenang dalam perlombaan AI ini bukanlah mereka yang hanya memiliki algoritma terbaik, tetapi mereka yang memiliki infrastruktur fisik paling tangguh untuk menjalankannya.

Seri Prakiraan Tren data center 2026 – Bagian 3 dari 4

Tahun 2026 bukan lagi tentang sekadar bangunan yang diisi server. Kita sedang menyaksikan transformasi total pada arsitektur pendinginan. Fokus industri bergeser dari sekadar efisiensi listrik (Power Usage Effectiveness atau PUE) menuju efisiensi air (Water Usage Effectiveness atau WUE). Artikel ini akan membahas bagaimana teknologi baru mematahkan mitos bahwa AI harus selalu boros air, terutama di iklim tropis.

Sepanjang tahun 2024 dan 2025, narasi media sering kali menyoroti betapa borosnya AI terhadap sumber daya air. Judul-judul berita utama sering menyebutkan bahwa “satu percakapan dengan chatbot setara dengan membuang sebotol air”. Namun, penting untuk memahami fisika di balik klaim ini.

Pada desain data center konvensional, panas dibuang melalui menara pendingin (cooling towers). Sistem ini bekerja dengan cara menguapkan air ke atmosfer untuk membuang panas. Dalam model lama ini, semakin keras chip bekerja (untuk melatih model AI), semakin banyak panas yang dihasilkan, dan semakin banyak air yang harus diuapkan. Laporan dari peneliti di University of California memperkirakan bahwa pelatihan GPT-3 saja mengonsumsi ribuan liter air.

Namun, di tahun 2026, korelasi linier antara “performa tinggi” dan “pemborosan air” ini mulai terputus. Industri data center mulai meninggalkan metode penguapan terbuka demi teknologi closed-loop (sirkulasi tertutup) yang jauh lebih canggih. Air yang telah digunakan tidak dibuang tetapi di-recycle agar dapat dipakai kembali.

Pergeseran ke kawasan Asia Pasifik (seperti yang dibahas di Bagian 2) membawa tantangan teknis tersendiri. Negara-negara seperti Indonesia, Singapura, dan Filipina memiliki tingkat kelembapan udara yang sangat tinggi.

Sistem pendingin evaporatif tradisional bekerja sangat tidak efisien di daerah tropis. Anda tidak bisa mendinginkan air secara efektif dengan menguapkannya ke udara yang sudah jenuh air (lembab). Akibatnya, operator data center sering kali harus membuang lebih banyak energi dan air hanya untuk menjaga suhu server tetap stabil.

Inilah yang mendorong lahirnya standar baru di tahun 2026: Teknologi Membran.

Untuk mengatasi “jebakan panas” di wilayah tropis tanpa menguras cadangan air tanah setempat, teknologi baru seperti sistem liquid cooling mulai menjadi standar bagi operator yang berwawasan ke depan.

Berbeda dengan menara pendingin tradisional yang menyemprotkan air ke udara, sistem ini menggunakan membran semi-permeabel—bayangkan seperti lapisan Gore-Tex raksasa untuk data center. Teknologi ini memisahkan air dari aliran udara. Membran tersebut memungkinkan panas keluar melalui uap air mikroskopis, tetapi menahan air cair agar tidak terbuang sia-sia dan mencegah kontaminan dari udara luar masuk ke sistem.

Hasilnya sangat signifikan untuk tren keberlanjutan 2026:

Penerapan teknologi ini bukan lagi sekadar teori. Perusahaan infrastruktur digital regional seperti Digital Edge telah mulai mengimplementasikan teknologi liquid cooling di fasilitas mereka, seperti di Indonesia dan Filipina, untuk membuktikan bahwa kepadatan daya tinggi (high density) bisa dicapai di iklim tropis tanpa mengorbankan efisiensi air. Ini adalah contoh nyata bagaimana inovasi fisik memungkinkan ekspansi AI di wilayah yang sebelumnya dianggap terlalu panas atau lembab.

Di tahun 2026, klien hyperscale (perusahaan raksasa teknologi) tidak lagi hanya bertanya “Berapa kapasitas listrik Anda?”, tetapi juga “Berapa angka WUE Anda?”.

Water Usage Effectiveness (WUE) menjadi metrik yang sama pentingnya dengan PUE. Di banyak negara, izin pembangunan data center baru semakin diperketat terkait penggunaan air tanah, terutama karena data center sering kali bersaing dengan kebutuhan air bersih masyarakat di sekitarnya.

Arsitektur data center masa depan akan bersifat “hibrida”. Di bagian atap, sistem membran (seperti liquid cooling) menciptakan siklus air dingin yang tertutup. Di dalam ruang server (data hall), air dingin tersebut dialirkan ke dua tujuan:

Kombinasi ini memungkinkan data center untuk menangani beban kerja AI yang sangat berat dengan jejak air yang hampir nol (near-zero water footprint).

Transformasi fisik data center di tahun 2026 adalah tentang menjadi “tidak terlihat” secara lingkungan, sehingga data center nantinya tidak mempengaruhi lingkungan sekitarnya. Tren utamanya adalah memisahkan pertumbuhan komputasi dari konsumsi sumber daya alam.

Masa depan infrastruktur AI bukanlah tentang menemukan lebih banyak air untuk dibuang ke atmosfer, melainkan merekayasa sistem agar limbah tersebut hilang sepenuhnya. Dengan adopsi teknologi pendingin berbasis membran dan liquid cooling, data center di tahun 2026 akan menjadi utilitas yang sunyi, dingin, dan hemat air, siap menopang revolusi kecerdasan buatan global.

Seri Prakiraan Tren data center 2026 – Bagian 2 dari 4

Kawasan Asia-Pasifik tengah mengalami transformasi infrastruktur digital yang belum pernah terjadi sebelumnya. Kawasan ini diperkirakan akan menyumbang sekitar 30% dari ekspansi kapasitas global selama lima tahun ke depan, dengan total investasi mencapai lebih dari $564 miliar hingga tahun 2028. Injeksi modal raksasa ini mengubah berbagai aspek, mulai dari komputasi awan (cloud) hingga penerapan kecerdasan buatan (AI). Sementara titik pusat legacy seperti Singapura dan Tokyo menghadapi kendala daya dan kelangkaan lahan, kelas baru pasar berkembang mulai menonjol—menciptakan peluang yang tidak tersedia beberapa bulan yang lalu.

Beberapa kekuatan konvergen menjadikan tahun 2026 sebagai titik balik bagi infrastruktur digital di seluruh kawasan.

Revolusi kecerdasan buatan generatif terus berlanjut. Beban kerja AI modern memerlukan rak berdensitas tinggi khusus dan sistem pendinginan canggih. Industri mencatat peningkatan rata-rata kepadatan daya rak server, dengan adopsi yang lebih luas pada rentang 10 kW hingga 30 kW; namun, fasilitas yang melebihi 30 kW masih relatif sedikit, dan fasilitas dengan kepadatan sangat tinggi masih jarang ditemui, sebagaimana dicatat dalam Survei data center Global 2025 dari Uptime Institute. Peningkatan densitas ini menciptakan permintaan mendesak terhadap fasilitas baru yang siap mendukung AI.

Pemerintah di seluruh Asia Tenggara memberlakukan persyaratan residensi data yang lebih ketat. Vietnam, Thailand, dan Indonesia telah memperkenalkan regulasi yang mengharuskan data keuangan dan pribadi tetap berada dalam batas wilayah nasional. Lonjakan yang didorong oleh kepatuhan ini mengharuskan perusahaan untuk tidak lagi mengarahkan semua proses melalui satu pusat tunggal seperti Singapura—mereka harus membangun fasilitas lokal di berbagai yurisdiksi secara bersamaan.

Berbagai pemilik modal (retail, privat, maupun negara) telah menilai data center sebagai aset portofolio yang berharga. Pasar telah menyediakan modal yang belum pernah terjadi sebelumnya, memungkinkan pengembangan secara cepat. Pasar data center Asia-Pasifik secara keseluruhan diproyeksikan tumbuh dengan Tingkat Pertumbuhan Tahunan Gabungan (CAGR) sebesar 12,40% dari tahun 2025 hingga 2035, didorong oleh joint ventures bernilai miliaran dolar ini.

Diskusi seputar ekspansi data center APAC selalu kembali pada isu daya—namun narasi telah bergeser dari “daya murah” menjadi “daya tersedia dan berkelanjutan.”

Goldman Sachs memperkirakan bahwa permintaan daya global dari data center akan meningkat 50% pada tahun 2027 dan diproyeksikan naik hingga 165% pada tahun 2030 dibandingkan dengan tingkat tahun 2023. Di pasar yang telah mapan, kondisi ini menciptakan kemacetan aliran daya. Moratorium Singapura baru-baru ini (kini dicabut dengan persyaratan keberlanjutan yang ketat) memaksa operator untuk mencari lokasi alternatif. Tokyo menghadapi kendala serupa, di mana beberapa developer harus menunggu 3-5 tahun untuk koneksi jaringan listrik.

Asia adalah rumah bagi 83% dari pembangkit listrik tenaga batu bara dunia, namun investasi listrik bersih kini secara signifikan sudah melampaui investasi bahan bakar fosil di kawasan ini. Total pangsa energi terbarukan gabungan di Asia mencapai 29% pada tahun 2024. Hyperscaler menuntut Perjanjian Pembelian Daya yang melingkupi energi terbarukan. Dan penyedia yang bisa menyuplai daya hijau murni mendapatkan harga premium—bahkan di pasar di mana batu bara masih mendominasi bauran jaringan listrik.

Baca juga: Penggerak Masa Depan : Integrasikan Energi Terbarukan di Data Center

Meskipun pendinginan udara tetap menjadi standar dasar untuk sebagian besar fasilitas, kebutuhan untuk mendukung klaster AI berdensitas ekstrem (umumnya lebih dari 30 kW per rak) mendorong adopsi pendinginan imersif dan direct-to-chip sebagai spesifikasi dasar untuk fasilitas yang baru dibangun. Hal ini mencerminkan tuntutan perangkat keras yang muncul di pasar.

Alih-alih langsung mendirikan kampus mega 100MW, operator membangun secara bertahap fase-fase berukuran 10-20MW yang bisa beroperasi dalam 12-18 bulan. Pendekatan ini menyesuaikan permintaan pelanggan sehingga memberikan fleksibilitas dalam ekspansi. Pendekatan ini mendominasi di pasar berkembang seperti Indonesia, di mana permintaan kuat namun bertahap.

Baca juga: Masa Depan Data Center Indonesia: Infrastruktur dan Investasi Makin Naik

Peran data center di APAC sedang bergeser dari model leased space tradisional menjadi pusat interkoneksi. Keberadaan fasilitas carrier-neutral dengan ekosistem yang kaya (termasuk industri jasa keuangan, enterprise, ISP, dsb.) menciptakan efek jaringan yang mendasari harga premium. Model ini menjadi aset berharga, khususnya di wilayah di mana kapasitas bandwidth internasional melesat tinggi, tetapi infrastruktur local exchange masih relatif minim.

Bagi perusahaan yang merencanakan penerapan 2026, pertimbangan strategis menjadi kompleks. Hyperscaler meluncurkan wilayah ketersediaan baru di seluruh APAC dengan skala yang belum pernah terjadi sebelumnya, namun pemilihan lokasi kini melibatkan evaluasi puluhan variabel di luar sekadar konektivitas.

Ketersediaan daya merupakan prioritas utama—apakah kapasitas 50 MW tersedia saat ini dengan potensi skalabilitas hingga 200 MW? Pasokan energi terbarukan menjadi pertimbangan krusial berikutnya, mengingat banyak RFP kini mensyaratkan 100% energi hijau sejak awal operasional. Faktor penting lainnya mencakup diversitas serat optik, risiko gempa, area rawan banjir, serta stabilitas regulasi setempat.

Inilah titik di mana spesialis regional menambah nilai. Perusahaan seperti Digital Edge, dengan pusat operasi di APAC, memiliki apa yang sulit ditawarkan oleh operator global: pemahaman mengenai standar regional dan juga local expertise. Terutama terkait birokrasi, lahan, serta daya yang mampu menopang kinerja hyperscale atau yang lebih besar lagi. Fasilitas operator regional telah dioptimalkan untuk iklim tropis; dan tata letak terdistribusi, hingga bisa mengurangi risiko lingkungan / bencana alam sambil tetap dekat dengan rute konektivitas terbaik.

Keunggulan ini bukan hanya operasional—tetapi juga temporal. Di pasar di mana mengamankan lahan dan daya dapat memakan waktu 18-24 bulan, bekerja dengan penyedia yang telah menyelesaikan pekerjaan dasar dapat mempercepat penerapan hingga satu tahun atau lebih.

Narasi data center APAC bukan hanya tentang kapasitas—tetapi tentang kapabilitas. Pada tahun 2026, kawasan ini akan bertransisi dari pengikut menjadi pemimpin dalam mendefinisikan arsitektur data center generasi berikutnya. Pasar-pasar di seluruh Asia Tenggara melampaui kendala warisan untuk menghadirkan infrastruktur yang siap AI, bertenaga berkelanjutan, dan terkoneksi secara hiper.

Bagi perusahaan yang merencanakan strategi digital 2026 mereka, pesannya jelas: pasar APAC yang berkembang bukan lagi opsi sekunder, melainkan tujuan penerapan utama. Pertanyaannya bukan lagi apakah akan membangun kehadiran, tetapi seberapa cepat kapasitas dapat diamankan sebelum pasar yang tumbuh cepat ini mengalami pengetatan. Ekspansi tidak akan datang—ekspansi telah terjadi.

Seri Prediksi Tren Data Center 2026 – Bagian 1 dari 4

Tahun 2026 semakin dekat, dan transformasi yang dibawa oleh kecerdasan buatan (AI) telah mengubah lanskap infrastruktur data center secara fundamental. Dalam seri empat artikel ini, kami akan mengeksplorasi tren-tren kunci yang akan membentuk masa depan industri data center di tahun mendatang. Artikel pertama ini berfokus pada dampak AI terhadap infrastruktur dan teknologi data center—mulai dari kebutuhan daya hingga evolusi hyperscale, inovasi sistem pendinginan, dan ide-ide revolusioner seperti data center di luar angkasa.

Baca juga: Mengenal Data Center AI: Spesifikasi Utama dan Perangkat Keras

AI membutuhkan daya komputasi yang jauh lebih tinggi dibandingkan aplikasi tradisional, terutama karena penggunaan GPU dan server akselerator berkinerja tinggi. Menurut laporan International Energy Agency (IEA), konsumsi listrik pusat data global diperkirakan mendekati 1.050 terawatt-hours (TWh) pada tahun 2026—angka yang akan menjadikannya sebagai konsumen listrik terbesar kelima di dunia.

Secara spesifik, AI telah menyumbang 5-15% dari penggunaan daya data center dalam beberapa tahun terakhir, dan angka ini bisa meningkat menjadi 35-50% pada tahun 2030 dalam skenario pertumbuhan tinggi. Di Amerika Serikat saja, data center menyumbang 4% dari total konsumsi listrik nasional pada 2024, dan permintaannya diproyeksikan lebih dari dua kali lipat pada 2030, sebagian besar didorong oleh boom AI.

Proyeksi dari MIT News menunjukkan bahwa permintaan listrik dari data center yang dioptimasi untuk AI bisa mencapai 90 TWh per tahun pada 2026. Lebih mengkhawatirkan lagi, analisis MIT Sloan mengungkapkan bahwa data center AI bisa mengonsumsi daya hingga 21% dari total permintaan energi global jika biaya pengiriman layanan AI ke pelanggan dihitung. Dampak ini mendorong pembangunan data center hyperscale yang lebih besar, dengan kapasitas mencapai ratusan megawatt untuk menangani beban komputasi AI yang masif.

AI tidak hanya meningkatkan kebutuhan daya, tetapi juga mendorong pertumbuhan data center hyperscale—fasilitas raksasa yang dirancang untuk skala global. Deloitte memperkirakan permintaan daya dari data center AI di AS bisa tumbuh lebih dari 30 kali lipat menjadi 123 GW pada 2035, yang memerlukan pembangunan hyperscale baru dengan desain modular dan fleksibel.

Tech giants seperti Alphabet, Amazon, Microsoft, dan Meta berencana menginvestasikan lebih dari US$350 miliar pada data center tahun ini dan US$400 miliar pada 2026, dengan fokus pada hyperscale yang mampu menangani workload AI seperti pelatihan model besar. Struktur Research memperkirakan bahwa hingga 2026, pasar data center global akan tumbuh secara signifikan berkat AI, dengan hyperscale menjadi tulang punggung untuk layanan cloud dan edge computing. Arsitektur ini juga mengadopsi pergeseran ke desain composable, di mana sumber daya seperti GPU dapat dialokasikan secara dinamis untuk efisiensi maksimal.

Di Indonesia, operator seperti EDGE DC menunjukkan tren ini dengan fasilitas hyperscale yang mendukung AI, termasuk integrasi teknologi canggih untuk skalabilitas.

Saat ini, sumber daya untuk data center masih berasal dari campuran grid nasional yang didominasi bahan bakar fosil. IEA memperkirakan bahwa gas alam dan batu bara akan memenuhi lebih dari 40% permintaan listrik tambahan dari data center hingga 2030.

Namun, energi terbarukan seperti surya, angin, hidro, dan geotermal semakin populer untuk mendukung pertumbuhan hyperscale. Di AS, yang memiliki 5.426 data center pada Maret 2025, transisi ke energi bersih menjadi prioritas. Di Indonesia, EDGE DC juga mengadopsi Renewable Energy Certificate (REC) dari PLN yang bersumber dari energi panas bumi.

Sistem pendinginan tradisional berbasis udara tidak lagi memadai untuk rack berdaya tinggi AI yang mencapai 100 kW+ per rack. Adopsi pendinginan cairan seperti direct-to-chip dan immersion cooling akan mendominasi pada 2026, menawarkan efisiensi energi 30-50% lebih baik.

Perusahaan terkemuka seperti Schneider Electric, Vertiv, dan LiquidStack memimpin inovasi dalam segmen ini. Di kawasan Asia-Pasifik, adopsi teknologi pendinginan inovatif semakin meningkat. EDGE DC, misalnya, telah mengimplementasikan StatePoint® Liquid Cooling System dari Nortek di fasilitas EDGE2 berkapasitas 23 MW—menjadikannya data center pertama di Indonesia yang menggunakan teknologi indirect evaporative cooling dengan membran semipermeabel. Teknologi ini secara signifikan mengurangi konsumsi listrik dan air tahunan, sekaligus dapat beradaptasi dengan kondisi iklim tropis yang panas dan lembab.

Pendekatan hibrida pendinginan cairan juga mengurangi penggunaan air hingga 90% di wilayah kering—solusi penting untuk daerah dengan kelangkaan air.

Baca juga: Bagaimana Gen AI Merevolusi Data Center

Inovasi Lokasi: Data Center di Luar Angkasa

Untuk mengatasi keterbatasan di Bumi, AI mendorong ide-ide inovatif seperti data center di luar angkasa. Google melalui Project Suncatcher sedang mengeksplorasi infrastruktur AI berbasis satelit, di mana chip TPU ditempatkan di orbit untuk memanfaatkan energi surya tak terbatas dan menghindari kendala daya serta ruang di darat.

Proyek ini, bekerja sama dengan Planet Labs, akan meluncurkan peralatan uji coba pertama pada awal 2027. Desainnya melibatkan kluster satelit yang terhubung melalui tautan optik antar-satelit, membentuk array sepanjang 1 km dengan 81 satelit untuk komputasi skalabel. Ini adalah “moonshot” untuk memenuhi permintaan AI yang melonjak, dengan potensi mengurangi biaya energi hingga 10 kali lipat dibandingkan data center darat, meskipun tantangan seperti pendinginan di ruang hampa dan latensi komunikasi masih perlu diatasi.

AI tidak hanya mempercepat inovasi tetapi juga merevolusi data center melalui hyperscale yang lebih besar, sistem pendinginan canggih, dan ide-ide ambisius seperti Project Suncatcher di luar angkasa. Tren ini memungkinkan penanganan workload AI yang masif, dari pelatihan model hingga inferensi real-time.

Bagi penyedia data center, masa depan terletak pada skalabilitas hyperscale, adopsi teknologi mutakhir, dan eksplorasi lokasi inovatif untuk tetap kompetitif di era AI yang akan mendominasi 2026. Kombinasi pertumbuhan eksponensial dan inovasi ini akan membentuk infrastruktur digital global yang lebih kuat dan adaptif.

Proyek infrastruktur bernama Candle Project baru saja diperkenalkan ke publik. Proyek ini bertujuan membangun sebuah sistem kabel bawah laut dengan kapasitas terbesar di kawasan Asia Pasifik (APAC).

Kabel ini akan menghubungkan Jepang, Taiwan, Filipina, Indonesia, Malaysia, dan Singapura, dengan total jarak mencapai 8.000 kilometer dan kapasitas transfer data hingga 570 terabit per detik (Tbps).

Dijadwalkan beroperasi pada tahun 2028, proyek Candle menjadi tonggak penting dalam upaya untuk memperluas infrastruktur digital globalnya, sekaligus memperkuat fondasi konektivitas internet dan layanan berbasis AI di kawasan dengan pertumbuhan ekonomi digital paling pesat di dunia.

Asia Pasifik saat ini menjadi rumah bagi lebih dari 58% pengguna internet dunia. Dengan meningkatnya ketergantungan pada layanan digital, kebutuhan akan jaringan berkapasitas tinggi dan latensi rendah menjadi sangat krusial.

Melalui proyek Candle, serta kabel Bifrost, Echo, dan Apricot, akan dipastikan ketersediaan kapasitas data lintas benua yang stabil dan efisien.

Kombinasi empat sistem kabel bawah laut ini akan menjadi tulang punggung konektivitas digital Asia Pasifik menuju Amerika dan kawasan lain di dunia.

Proyek Candle bukan sekadar investasi di bidang telekomunikasi bawah laut; kabel ini juga membawa dampak signifikan terhadap perkembangan industri data center di kawasan Asia Tenggara.

Kapasitas besar dan koneksi lintas regional ini akan menciptakan:

Sebagai penyedia data center yang fokus pada keandalan, efisiensi energi, dan konektivitas tinggi, EDGE DC melihat proyek seperti Candle Project sebagai peluang strategis untuk memperluas ekosistem data lokal dengan dukungan infrastruktur global yang tangguh.

Investasi pada proyek Candle, Bifrost, Echo, dan Apricot merupakan bagian dari komitmen dalam membangun jaringan digital global yang tangguh dan berkapasitas tinggi.

Langkah ini sejalan dengan visi jangka panjang untuk mendukung akses yang lebih luas terhadap layanan berbasis AI dan teknologi baru bagi miliaran pengguna internet di seluruh dunia.

Dengan meningkatnya ketersediaan konektivitas lintas negara, operator data center seperti EDGE DC akan berperan penting dalam memastikan transfer data berjalan cepat, efisien, dan aman—menjadi penghubung utama antara infrastruktur global dan pengguna akhir lokal.

Candle Project menandai babak baru dalam pengembangan konektivitas Asia Pasifik. Dengan kapasitas ratusan terabit per detik dan jangkauan lintas negara, sistem ini akan memperkuat fondasi transformasi digital di kawasan dengan pertumbuhan tercepat di dunia.

Di sisi lain, kehadiran kabel bawah laut berkapasitas besar ini juga membuka peluang bagi ekosistem data center untuk berkembang sebagai bagian integral dari jaringan digital global.

Konektivitas internet bukan lagi sekadar pelengkap, melainkan tulang punggung operasional setiap bisnis. Dari startup hingga perusahaan multinasional, ketergantungan pada jaringan yang cepat, stabil, dan skalabel terus meningkat. Namun, di balik kecepatan akses yang kita nikmati, ada perubahan fundamental yang sedang terjadi: transisi dari IPv4 ke IPv6.

Memahami perbedaan dan urgensi migrasi ini adalah kunci untuk memastikan bisnis Anda tetap relevan dan kompetitif di masa depan digital.

IPv4 (Internet Protocol version 4), protokol yang telah menjadi fondasi internet selama puluhan tahun, didasarkan pada skema alamat 32-bit. Ini berarti hanya ada sekitar 4,3 miliar alamat unik yang bisa dialokasikan. Pada masa perancangannya, angka ini dianggap lebih dari cukup. Namun, pertumbuhan internet yang eksplosif—dengan miliaran smartphone, perangkat Internet of Things (IoT), server data center, dan infrastruktur digital lainnya—dengan cepat mengikis cadangan alamat tersebut.

Sejak sekitar awal 2010-an, badan-badan yang mengatur alokasi IP global, termasuk di kawasan Asia Pasifik, telah secara resmi mengumumkan habisnya pasokan alamat IPv4. Di Indonesia, kelangkaan ini terasa jelas, memaksa banyak penyedia layanan internet (ISP) untuk menggunakan metode seperti Network Address Translation (NAT) secara ekstensif. NAT, meskipun menjadi solusi sementara untuk memungkinkan banyak perangkat berbagi satu alamat IP publik, sejatinya menambah lapisan kompleksitas dan dapat menimbulkan tantangan performa.

Baca juga: IP Peering vs IP Transit: Mana yang Tepat untuk Jaringan Anda?

Bagi bisnis modern yang sangat mengandalkan infrastruktur digital—terutama bagi mereka yang menggunakan layanan colocation data center untuk server dan aplikasi krusial—kelangkaan IPv4 membawa konsekuensi serius:

Bagi EDGE DC dan klien kami yang mengutamakan uptime tinggi, skalabilitas, dan efisiensi konektivitas, masalah IPv4 bukan lagi isu teknis semata, melainkan risiko bisnis yang perlu dimitigasi.

IPv6 (Internet Protocol version 6) hadir sebagai evolusi krusial yang dirancang untuk mengatasi keterbatasan IPv4. Dengan arsitektur 128-bit, IPv6 menawarkan jumlah alamat yang astronomis: sekitar 3.4 x 1038 alamat unik. Angka ini menjamin bahwa setiap perangkat di muka bumi, bahkan setiap atom di alam semesta, dapat memiliki alamat IP-nya sendiri, menghilangkan kekhawatiran kelangkaan untuk selamanya.

Lebih dari sekadar kuantitas alamat, IPv6 juga membawa perbaikan fundamental yang meningkatkan performa dan keamanan jaringan:

Transisi global dari IPv4 ke IPv6 adalah proses yang bertahap, seringkali melibatkan implementasi dual-stack di mana jaringan mendukung kedua protokol secara bersamaan. Untuk bisnis dan data center, kesuksesan transisi ini sangat bergantung pada dukungan dari ISP yang proaktif.

Penyedia konektivitas premium seperti CBN, melalui layanan CBN Premier Connectivity, telah berada di garis depan dalam menyediakan dukungan IPv6 native yang kuat dan terintegrasi. Hal ini memungkinkan bisnis yang menempatkan infrastruktur mereka di data center seperti EDGE DC untuk mengadopsi IPv6 dengan mulus tanpa kendala kompatibilitas.

Dengan dukungan ISP yang tepat, pengguna EDGE DC dapat:

Sebagai data center carrier-neutral, EDGE DC memberikan keleluasaan bagi klien untuk memilih ISP yang paling sesuai, termasuk penyedia dengan kemampuan IPv6 mumpuni seperti CBN. Kombinasi ini menjamin fleksibilitas dan ketahanan maksimal dalam membangun arsitektur jaringan yang adaptif dan siap menghadapi setiap dinamika digital.

Baca juga: Perbedaan Mendasar Internet Fiber Optik untuk Bisnis vs. Rumahan

Kelangkaan IPv4 bukan lagi ancaman di masa depan—ini adalah realitas operasional saat ini. Bisnis yang visioner dan proaktif dalam mengadopsi strategi IPv6-ready network akan memiliki keunggulan kompetitif yang signifikan. Mereka tidak hanya akan terbebas dari batasan alamat IP, tetapi juga akan menikmati efisiensi operasional yang lebih baik, keamanan yang ditingkatkan, dan fondasi yang solid untuk inovasi berkelanjutan.

Dalam merencanakan strategi konektivitas Anda, sangat penting untuk memilih mitra yang memahami dan telah mengimplementasikan transisi IPv6 secara komprehensif. Dengan bermitra bersama penyedia jaringan terkemuka seperti CBN yang berkomitmen pada standar teknologi terbaru, serta menempatkan infrastruktur di data center modern seperti EDGE DC, perusahaan Anda dapat memastikan fondasi konektivitas yang kuat, aman, dan skalabel untuk mendukung ambisi digital di masa depan.

Satu detik downtime bisa berarti kehilangan ribuan pelanggan. Bayangkan sebuah situs e-commerce saat flash sale atau aplikasi perbankan di tanggal gajian; lonjakan trafik yang masif bisa membuat server kewalahan dan akhirnya tumbang. Inilah masalah yang ingin dipecahkan oleh load balancing.

Bagi pengembang, administrator sistem, atau pemilik bisnis, memahami apa itu load balancing bukan lagi pilihan, melainkan sebuah keharusan untuk membangun aplikasi yang andal dan dapat diskalakan.

Artikel ini akan membahas tuntas konsep apa itu load balancing server, mulai dari cara kerjanya, jenis-jenisnya, hingga contoh arsitektur sederhana yang bisa Anda terapkan. Mari kita mulai.

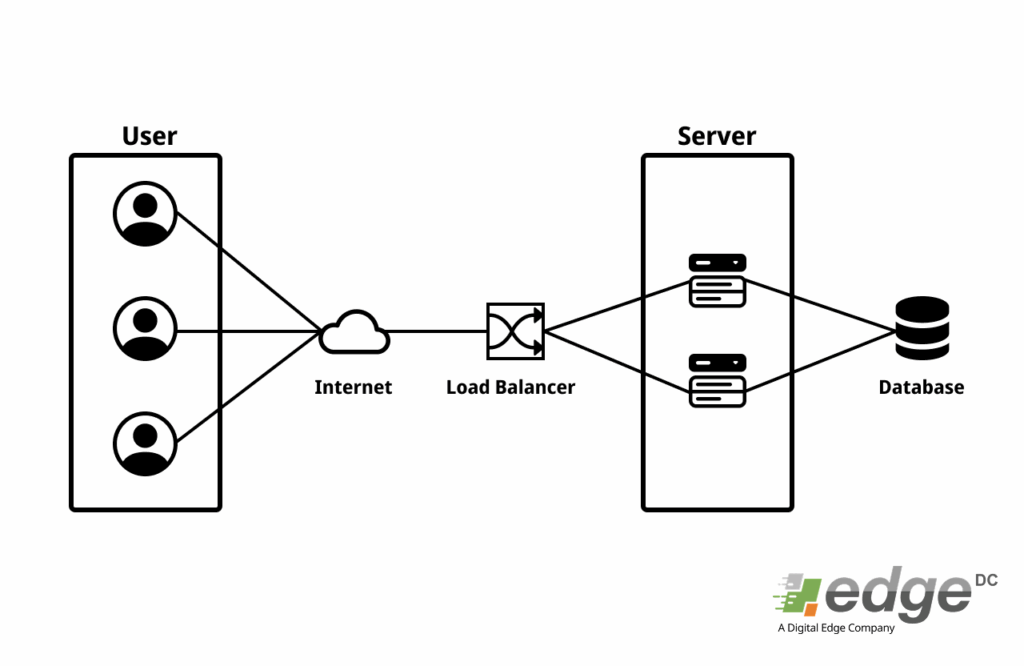

Secara sederhana, load balancing adalah proses mendistribusikan lalu lintas (trafik) jaringan atau aplikasi secara merata ke beberapa server di belakangnya. Anggap saja load balancer sebagai seorang manajer lalu lintas yang cerdas di depan sebuah jalan tol dengan banyak gerbang. Alih-alih membiarkan semua mobil menumpuk di satu gerbang, manajer ini mengarahkan mobil ke gerbang-gerbang yang lebih sepi untuk memastikan tidak ada antrian panjang dan semua berjalan lancar.

Dalam dunia digital, “mobil” adalah permintaan dari pengguna (seperti membuka halaman web atau melakukan transaksi), dan “gerbang tol” adalah server Anda. Load balancer berada di antara pengguna dan server farm Anda, bertindak sebagai titik masuk tunggal yang kemudian menyebarkan beban kerja secara efisien.

Penerapan load balancing memberikan tiga keuntungan utama yang krusial bagi aplikasi modern:

Baca juga: Vertical vs Horizontal Scaling: Menentukan Arah Skalabilitas Infrastruktur Anda

Load balancer tidak bekerja dengan cara yang sama. Perbedaan utamanya terletak pada lapisan (layer) Model OSI di mana mereka beroperasi. Dua jenis yang paling umum adalah Layer 4 dan Layer 7.

Load balancer Layer 4 bekerja pada tingkat jaringan. Ia membuat keputusan perutean berdasarkan informasi dari lapisan transport, seperti alamat IP sumber/tujuan dan nomor port.

Ini adalah jenis load balancer yang lebih canggih dan umum digunakan untuk load balancer web app. Ia bekerja pada lapisan aplikasi, artinya ia dapat “membaca” dan memahami konten dari permintaan, seperti HTTP headers, cookies, dan URL.

Untuk memaksimalkan fungsinya, load balancer didukung oleh beberapa konsep penting:

Ada banyak pilihan perangkat lunak load balancer, baik open-source maupun komersial. Berikut tiga yang paling populer:

Mari visualisasikan bagaimana semua ini bekerja bersama dalam sebuah arsitektur sederhana:

Load balancing bukan lagi sebuah kemewahan, melainkan komponen fundamental dalam merancang arsitektur aplikasi yang tangguh, cepat, dan skalabel. Dengan mendistribusikan beban kerja secara cerdas, ia tidak hanya menjaga performa aplikasi di level puncak tetapi juga memberikan jaring pengaman yang krusial untuk memastikan layanan Anda tetap berjalan bahkan ketika terjadi masalah pada salah satu server.

Memilih jenis load balancer yang tepat (Layer 4 atau Layer 7) dan mengkonfigurasi fitur seperti health checks dan session persistence akan menjadi kunci kesuksesan infrastruktur digital Anda.

Bayangkan aplikasi atau website yang Anda bangun digunakan jutaan orang. Pengguna berdatangan, trafik meroket, dan server yang tadinya berjalan lancar kini mulai terasa lambat. Ini adalah masalah yang bagus untuk dimiliki, tetapi juga merupakan titik kritis yang menentukan masa depan produk Anda. Jawabannya terletak pada satu kata: skalabilitas.

Jawabannya terletak pada satu kata: skalabilitas. Skalabilitas ini tak terlepas dari infrastruktur fisik tempat server Anda berjalan, seringkali berada di sebuah data center. Namun, skalabilitas bukanlah trik sihir. Ada dua pilihan utama yang sering menjadi perdebatan di kalangan developer dan DevOps: vertical scaling dan horizontal scaling. Memilih jalan yang salah tidak hanya boros biaya, tetapi juga bisa menyebabkan downtime dan merusak pengalaman pengguna.

Artikel ini akan mengupas tuntas apa itu vertical scaling, apa itu horizontal scaling, dan perbandingan horizontal vs vertical scaling. Tujuannya agar Anda bisa membuat keputusan yang tepat tentang arah skalabilitas infrastruktur Anda.

Vertical scaling adalah proses meningkatkan kapasitas satu server yang ada dengan menambahkan lebih banyak sumber daya. Bayangkan Anda memiliki satu koki yang sangat andal. Ketika pesanan membludak, Anda tidak merekrut koki baru, melainkan memberinya pisau yang lebih tajam, kompor yang lebih besar, dan meja kerja yang lebih luas. Dia tetap satu orang, tetapi kini lebih kuat dan lebih cepat.

Itulah esensi dari vertical scaling, atau yang sering disebut juga scale-up.

Horizontal scaling adalah proses menambah lebih banyak server atau instance untuk mendistribusikan beban kerja. Kembali ke analogi koki tadi. Alih-alih membuat satu koki menjadi “super”, Anda merekrut lebih banyak koki. Setiap koki mengerjakan sebagian pesanan, dan secara kolektif, mereka bisa menangani volume yang jauh lebih besar.

Inilah inti dari horizontal scaling, atau scale-out. Anda tidak membuat satu server menjadi lebih besar, tetapi Anda menambah jumlah server.

Untuk mempermudah, mari kita bandingkan keduanya dalam sebuah tabel:

| Aspek | Vertical Scaling (Scale-Up) | Horizontal Scaling (Scale-Out) |

|---|---|---|

| Konsep Dasar | Memperbesar satu server (menambah CPU/RAM). | Menambah lebih banyak server (menambah instance). |

| Batas Skalabilitas | Terbatas oleh kapasitas hardware maksimum. | Hampir tak terbatas, selama arsitektur mendukung. |

| Ketersediaan | Rendah. Ada Single Point of Failure. | Tinggi. Kegagalan satu node tidak mematikan sistem. |

| Kompleksitas | Rendah di awal, mudah diimplementasikan. | Tinggi, butuh load balancer dan desain aplikasi. |

| Biaya | Biaya hardware kelas atas sangat mahal. | Lebih efisien, bisa menggunakan hardware standar. |

| Dampak Aplikasi | Umumnya tidak memerlukan perubahan kode. | Aplikasi harus dirancang untuk lingkungan terdistribusi. |

Di era modern, horizontal scaling menjadi jauh lebih mudah berkat teknologi seperti containerization dan orchestration.

Docker dan Kubernetes adalah pilar utama yang menjadikan horizontal scaling sebagai strategi dominan untuk aplikasi modern.

Tidak ada jawaban “satu untuk semua”. Pilihan antara vertical vs horizontal scaling tergantung pada kebutuhan, arsitektur, dan anggaran Anda.

Pada praktiknya, banyak sistem modern menggunakan pendekatan hibrida: menerapkan vertical scaling untuk komponen tertentu yang sulit didistribusikan (seperti database utama) dan horizontal scaling untuk komponen lain yang stateless (seperti server aplikasi web).

Perencanaan skalabilitas adalah investasi. Dengan memahami perbedaan fundamental antara scale-up dan scale-out, Anda dapat membangun fondasi infrastruktur yang tidak hanya kuat hari ini, tetapi juga siap untuk pertumbuhan di masa depan.

Bagi sebuah organisasi, terutama yang memiliki banyak kantor cabang atau tim tersebar di berbagai wilayah, jaringan komunikasi yang stabil dan aman adalah kebutuhan penting. Dalam konteks ini, muncul teknologi Wide Area Network (WAN), sebuah arsitektur jaringan yang memungkinkan perusahaan menghubungkan kantor cabang, data center, bahkan unit bisnis di berbagai lokasi yang berjauhan.

Namun, seiring perkembangan teknologi, WAN tradisional kini memiliki penerus yang lebih cerdas dan fleksibel, yaitu SD-WAN (Software-Defined Wide Area Network). Agar lebih mudah memahami evolusi ini, mari kita mulai dengan mengenal WAN terlebih dahulu: pengertian, cara kerja, jenis, hingga manfaatnya bagi bisnis.

WAN (Wide Area Network) adalah jaringan komputer yang mencakup area geografis luas, berfungsi untuk menghubungkan berbagai jaringan lokal (LAN) atau metropolitan (MAN) di lokasi berbeda agar tetap terintegrasi.

Contoh sederhana adalah jaringan perbankan yang menghubungkan kantor cabang di seluruh Indonesia dengan pusat data nasional, atau perusahaan multinasional yang mengintegrasikan operasional dari berbagai negara.

Tujuan utama WAN adalah memungkinkan komunikasi, berbagi data, aplikasi, serta sumber daya jaringan antar lokasi, tanpa batasan geografis.

WAN bekerja dengan cara menghubungkan beberapa LAN atau MAN menggunakan perangkat dan infrastruktur komunikasi khusus, seperti router, leased line, jaringan MPLS, atau internet publik. Data yang dikirimkan melewati jalur komunikasi ini sebelum sampai ke tujuan.

Berikut gambaran cara kerja dasarnya:

WAN tidak hanya ada dalam satu bentuk. Berikut beberapa jenis WAN yang umum digunakan:

WAN memiliki peran penting dalam menunjang operasional modern. Berikut beberapa manfaat utamanya:

Perusahaan dapat menghubungkan kantor pusat, cabang, gudang, dan mitra bisnis dalam satu jaringan terpadu.

Karyawan di lokasi terpencar bisa mengakses aplikasi, file, atau database perusahaan secara real-time.

WAN memungkinkan akses ke data center pusat maupun aplikasi berbasis cloud dengan aman dan konsisten.

Perusahaan bisa dengan mudah menambah cabang baru tanpa harus membangun sistem jaringan lokal dari nol.

Sangat relevan untuk organisasi internasional yang beroperasi di banyak wilayah.

Meskipun memiliki banyak manfaat, WAN konvensional juga menghadapi beberapa kendala:

Keterbatasan inilah yang pada akhirnya mempercepat munculnya inovasi berupa SD-WAN, yang menawarkan otomatisasi, fleksibilitas, serta efisiensi biaya jauh lebih baik. Jika WAN tradisional adalah pondasi, maka SD-WAN bisa disebut sebagai evolusi cerdas dari WAN tradisional.

WAN (Wide Area Network) adalah teknologi jaringan utama yang memungkinkan konektivitas antar-cabang perusahaan di berbagai lokasi geografis. Dengan dukungan WAN, integrasi bisnis lintas kota maupun negara menjadi lebih mudah, meskipun tetap diiringi biaya tinggi dan pengelolaan yang kompleks.

EDGE DC sebagai provider data center terdepan di Indonesia menyediakan infrastruktur modern yang aman, andal, dan terhubung langsung dengan berbagai jaringan. Dengan dukungan solusi WAN maupun SD-WAN, Anda bisa memastikan bisnis tetap terkoneksi secara efisien dan tanpa hambatan.

Hubungi EDGE DC hari ini untuk konsultasi dan temukan solusi terbaik bagi kebutuhan data center dan jaringan perusahaan Anda.

Data center adalah ekosistem yang kompleks. Di dalamnya terdapat ratusan hingga ribuan server, perangkat jaringan, sistem pendingin, dan unit daya yang semuanya harus bekerja serentak tanpa henti. Mengelola semua komponen ini secara manual hampir mustahil dilakukan. Inilah mengapa teknologi manajemen canggih menjadi krusial, tidak hanya bagi operator data center, tetapi juga bagi Anda sebagai klien.

Salah satu teknologi terpenting dalam manajemen data center modern adalah DCIM atau Data Center Infrastructure Management. Namun, apa sebenarnya DCIM itu, dan yang lebih penting, bagaimana teknologi ini memberikan manfaat langsung bagi Anda saat menggunakan layanan colocation?

Secara sederhana, DCIM (Data Center Infrastructure Management) adalah solusi perangkat lunak terpusat yang berfungsi untuk memantau, mengukur, mengelola, dan mengoptimalkan seluruh infrastruktur fisik di dalam sebuah data center. Anggap saja DCIM sebagai “panel kontrol digital” yang memberikan gambaran menyeluruh tentang semua yang terjadi di dalam fasilitas, mulai dari rak server individual hingga sistem pendingin berskala besar.

Fungsi inti dari sistem DCIM meliputi:

Meskipun DCIM adalah alat yang dioperasikan oleh penyedia data center, manfaatnya meluas secara langsung kepada Anda sebagai klien yang menitipkan aset IT kritikal. Berikut adalah lima keuntungan utama yang Anda dapatkan:

Dulu, untuk mengetahui kondisi pasti dari server Anda di fasilitas colocation, Anda mungkin perlu melakukan kunjungan fisik. Dengan DCIM, transparansi menjadi jauh lebih mudah. Banyak penyedia data center modern, termasuk EDGE DC, menyediakan customer portal yang terintegrasi dengan sistem DCIM mereka.

Melalui portal ini, Anda bisa mendapatkan visibilitas penuh terhadap lingkungan Anda dari jarak jauh, seperti:

Transparansi ini memberi Anda ketenangan pikiran karena Anda tahu persis apa yang terjadi dengan infrastruktur Anda setiap saat.

DCIM mengubah data operasional menjadi wawasan yang dapat ditindaklanjuti. Sebagai klien, Anda dapat memanfaatkan data ini untuk membuat keputusan strategis terkait infrastruktur IT Anda.

Misalnya, dengan data konsumsi daya dari DCIM, Anda bisa:

Ini membantu Anda dalam mengelola skalabilitas dan pertumbuhan bisnis dengan lebih efektif dan berbasis data.

Salah satu manfaat terbesar DCIM adalah kemampuannya untuk mendeteksi potensi masalah sebelum menjadi gangguan besar. Sistem DCIM secara proaktif memantau setiap komponen penting data center.

Jika ada anomali—misalnya, suhu rak yang mulai naik atau lonjakan daya yang tidak wajar—sistem akan secara otomatis mengirimkan peringatan kepada tim operasional data center. Respons yang cepat ini memungkinkan mereka melakukan tindakan preventif, sehingga mencegah terjadinya downtime yang dapat merugikan bisnis Anda. Keandalan yang lebih tinggi ini secara langsung berdampak pada kelangsungan layanan digital Anda.

Banyak perusahaan kini memiliki target Environmental, Social, and Governance (ESG) atau keberlanjutan. Memilih mitra data center yang tepat dapat membantu Anda mencapai tujuan ini. DCIM memainkan peran kunci dalam operasional Green Data Center.

Dengan terus memonitor dan mengoptimalkan penggunaan energi, data center dapat menekan jejak karbonnya. Bagi Anda sebagai klien, ini berarti infrastruktur Anda di-hosting di fasilitas yang efisien dan bertanggung jawab terhadap lingkungan, yang sejalan dengan nilai-nilai perusahaan Anda.

Bagi tim IT Anda, DCIM menyederhanakan banyak tugas manajemen. Melalui customer portal, Anda tidak hanya bisa memantau, tetapi juga melakukan permintaan layanan dengan lebih mudah. Contohnya, jika Anda membutuhkan bantuan teknis di lokasi (layanan remote hands), Anda bisa membuat tiket permintaan langsung melalui portal yang terintegrasi.

Hal ini menghemat waktu dan sumber daya, memungkinkan tim Anda untuk fokus pada tugas-tugas strategis lainnya daripada mengurus logistik operasional.

Pada akhirnya, implementasi DCIM oleh penyedia data center adalah cerminan dari komitmen mereka terhadap keunggulan operasional, transparansi, dan keandalan. Teknologi ini bukan lagi sekadar “fitur tambahan”, melainkan komponen fundamental dari layanan data center tepercaya.

Sebagai klien, manfaat DCIM memberi Anda kontrol lebih besar, wawasan yang lebih dalam, dan keyakinan bahwa aset digital Anda berada di tangan yang tepat. Dengan infrastruktur yang dipantau dan dikelola secara proaktif, Anda dapat lebih fokus untuk mendorong inovasi dan pertumbuhan bisnis Anda.

Tertarik untuk mengetahui lebih lanjut bagaimana EDGE DC memanfaatkan teknologi canggih seperti DCIM untuk memberikan layanan terbaik bagi infrastruktur digital Anda? Hubungi tim kami hari ini untuk mendapatkan solusi yang tepat bagi kebutuhan bisnis Anda.